毎回,グラフを作るときに忘れてしまうので,メモとして書き残しておこう。

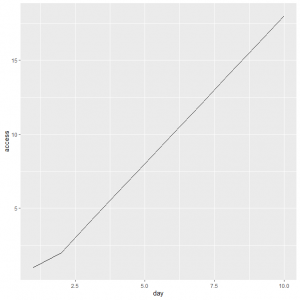

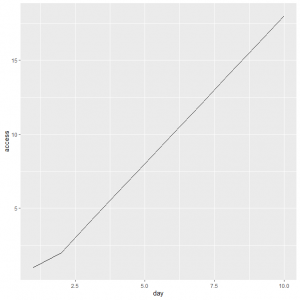

まずは,サンプルデータで,基本的な折れ線グラフを書く。

library(ggplot2)

data.frame(day = 1:10, access =c(1,2,4,6,8,10,12,14,16,18))

ggplot(dat,aes(x=day, y=access))+geom_line()

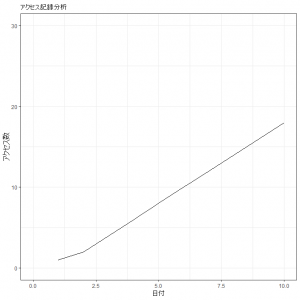

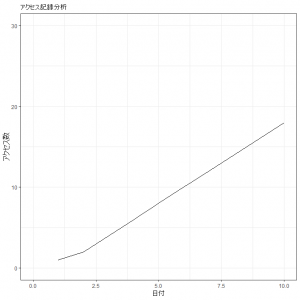

見た目の変更1

ggplot(dat,aes(x=day, y=access))+geom_line()+ylim(0,30)+xlim(0,10)+labs(x="日付", y="アクセス数", title="アクセス記録分析")+theme_bw()

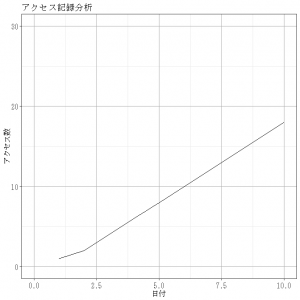

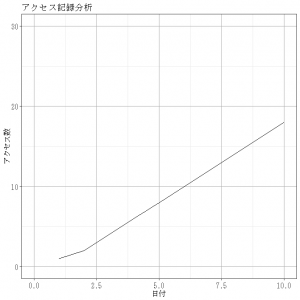

見た目の変更2

ggplot(dat, aes(x=day, y=access)) + geom_line()+ylim(0,30)+xlim(0,10)+labs(x="日付", y="アクセス数", title="アクセス記録分析")+theme_bw()+theme(panel.grid.major = element_line(colour = "#AAAAAA"), text=element_text(size=12, family="mincho"), axis.text.x = element_text(size=12),axis.text.y = element_text(size=12))

ポイント

theme(panel.grid.major = element_line(colour = “#AAAAAA”), text=element_text(size=12, family=”mincho”), axis.text.x = element_text(size=12),axis.text.y = element_text(size=12))

theme(panel.grid.major = element_line(colour = "#AAAAAA"), #補助線の目盛りのある方(major)の色を少し濃い目のグレーにする

text=element_text(size=12, family="mincho"), #図に中の文字フォントのサイズとフォントを変更

axis.text.x = element_text(size=12),#x軸の目盛りの数字を大きく

axis.text.y = element_text(size=12))#y軸の目盛りの数字を大きく